Vertex AI의 Gemini 임베딩 모델 확장

Vertex AI의 가장 강력한 텍스트 임베딩 모델인 gemini-embedding-001의 할당량 및 입력 크기 제한을 상향 조정

Gemini embedding model 사용시 요청당 단일 텍스트 대신 최대 250개의 입력 텍스트를 전송하여 250개의 임베딩을 생성할 수 있으며, 이를 통해 대규모 임베딩 애플리케이션의 처리량이 향상되고 왕복 네트워크 지연 시간이 감소합니다. 또한 대부분의 사용자를 위해 이 모델의 할당량 한도를 10배 늘려, 임베딩 애플리케이션을 분당 수백만 토큰 이상으로 손쉽게 확장할 수 있도록 지원합니다.

💡 Vertex AI의 Gemini 임베딩 모델이란?

Gemini 임베딩 모델은 텍스트를 숫자 벡터(임베딩)로 변환하여 검색, 유사성 분석, 클러스터링과 같은 작업에 필요한 semantic meaning을 포착합니다.

gemini-embedding-001 모델은 Vertex AI 텍스트 임베딩 API를 통해 고품질의 임베딩을 제공하며, 이는 검색 증강 생성(RAG)과 같은 다양한 애플리케이션을 위해 영어 전용 버전과 다국어 버전을 지원합니다.

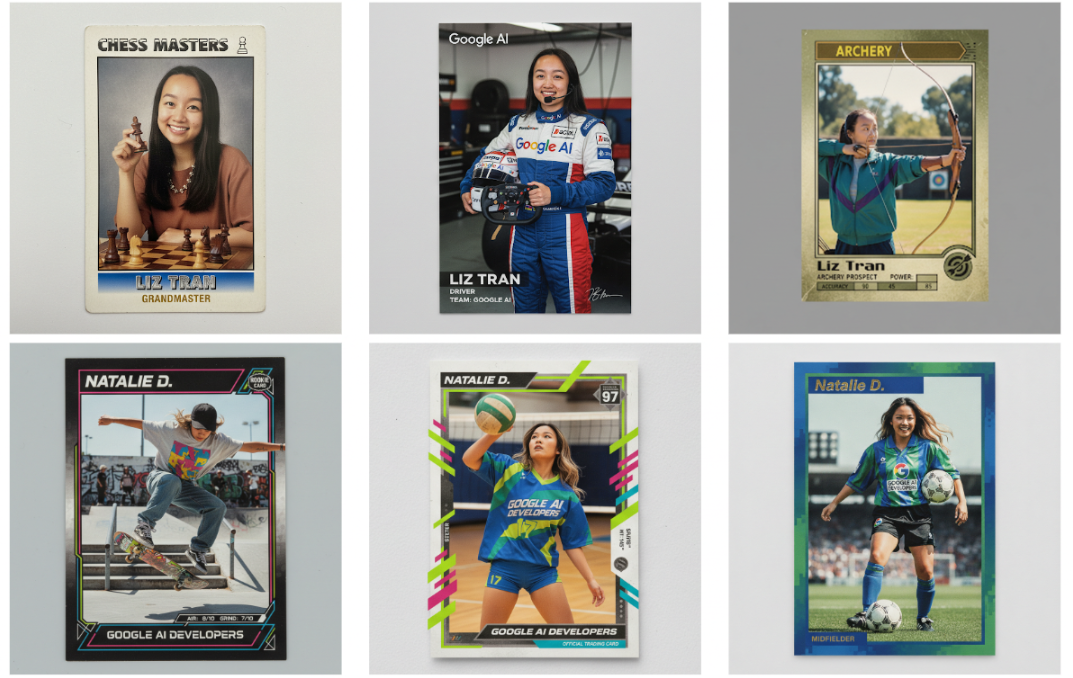

Gemini 2.5 Flash Image (aka nano-banana)

여러 이미지를 하나의 이미지로 합성하고, 풍부한 스토리텔링을 위해 캐릭터의 일관성을 유지하며, 자연어를 사용하여 특정 부분을 변형하고, Gemini의 세계 지식을 활용하여 이미지를 생성하고 편집할 수 있습니다.

- 다중 이미지 융합: 여러 이미지를 하나의 매끄러운 새 비주얼로 결합합니다. 마케팅, 교육 또는 광고와 같은 사용 사례를 위해 여러 참조 이미지를 사용하여 단일의 통합된 이미지를 만들 수 있습니다.

- 캐릭터 및 스타일 일관성: 여러 번 이미지를 생성해도 동일한 피사체나 시각적 스타일을 유지합니다. 시간이 많이 걸리는 미세 조정(fine-tuning) 없이도 동일한 캐릭터나 제품의 정체성을 잃지 않고 다른 장면에 쉽게 배치할 수 있습니다.

- 대화형 편집: 간단하고 자연스러운 언어 지시로 이미지를 편집합니다. 단체 사진에서 사람을 제거하는 것부터 얼룩과 같은 작은 디테일을 수정하는 것까지, 간단한 대화를 통해 변경할 수 있습니다.

일관성 있는 특성 유지

이미지 생성의 근본적인 과제 중 하나는 여러 프롬프트와 편집 과정에서 캐릭터나 객체의 외형을 유지하는 것으로 동일한 캐릭터를 다른 환경에 배치하고, 단일 제품을 새로운 배경에서 여러 각도로 보여주거나, 일관된 브랜드 자산을 생성하는 등, 피사체를 그대로 유지하면서 모든 작업을 수행할 수 있습니다.

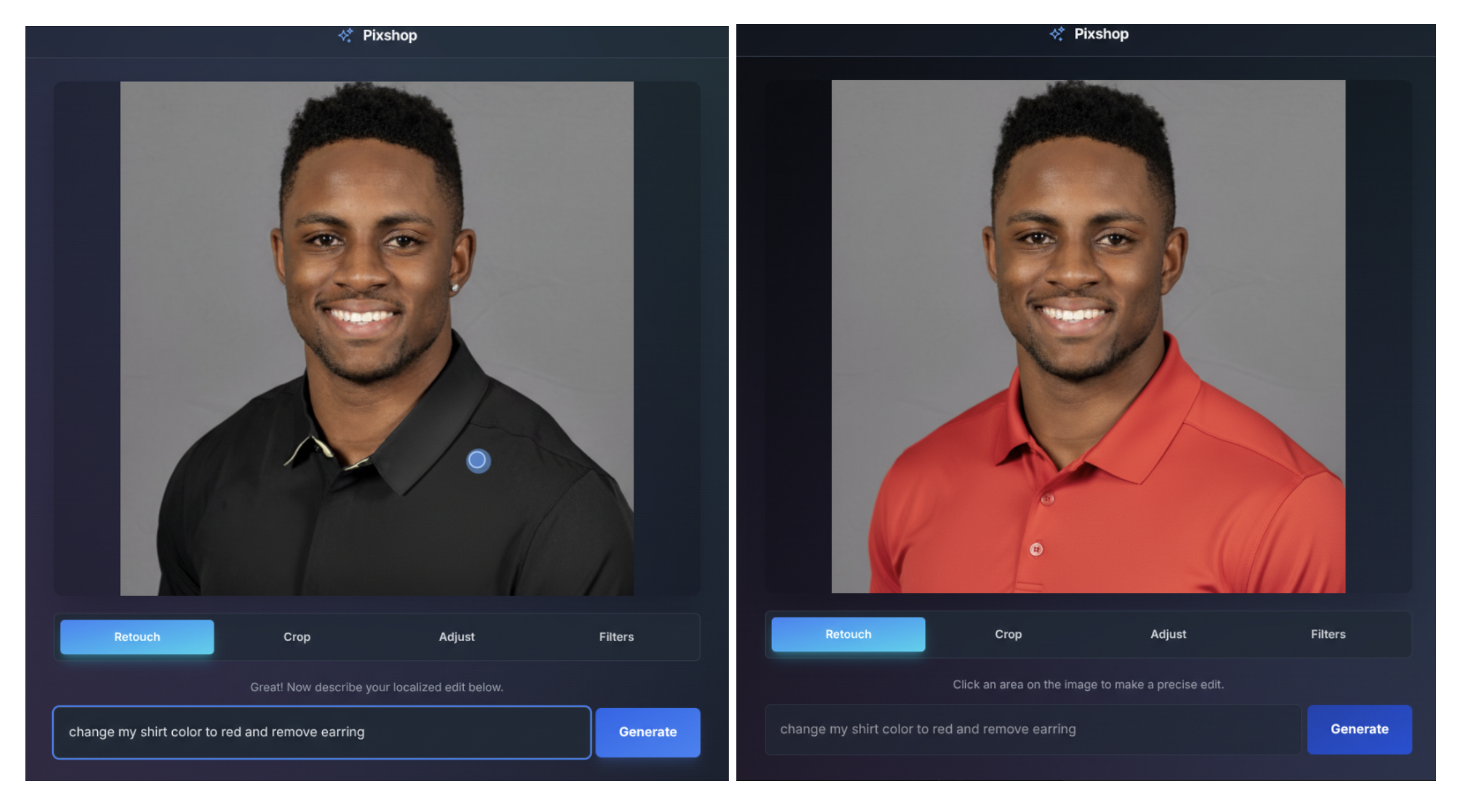

프롬프트 기반으로 이미지 편집

Gemini 2.5 Flash Image는 자연어를 통해 특정 변형과 정밀한 부분 편집을 가능하게 합니다. 예를 들어, 이 모델은 이미지의 배경을 흐리게 처리하고, 티셔츠의 얼룩을 제거하며, 사진에서 사람 전체를 삭제하고, 피사체의 포즈를 변경하고, 흑백 사진에 색을 추가하는 등 간단한 프롬프트로 상상할 수 있는 모든 것을 할 수 있습니다.

이외에도 현실 세계에 대한 깊은 의미를 이해하는 World knowledge 활용, 여러 입력 이미지를 이해하고 병합할 수 있습니다.

Blog : https://developers.googleblog.com/en/introducing-gemini-2-5-flash-image/

Docs: https://cloud.google.com/vertex-ai/generative-ai/docs/models/gemini/2-5-flash

URL context tool for Gemini Studio

⚠️ Vertex AI에서는 Pre-GA

개발자가 콘텐츠를 수동으로 업로드하는 대신 URL 형태로 모델에 추가적인 컨텍스트를 제공하여, 더 강력하고 문맥을 잘 파악하는 생성형 AI 애플리케이션을 구현할 수 있습니다.

기본적으로 Gemini 모델은 정적인 지식 기반을 가지며 인터넷에 직접 접근할 수 없습니다. Google 검색을 통한 그라운딩(Grounding)은 모델을 웹에 연결하여 광범위하고 실시간적인 정보 탐색을 가능하게 하고 더 깊은 분석을 위해, URL context tool은 검색 스니펫을 넘어 특정 웹페이지의 전체 콘텐츠를 모델이 수집하고 추론할 수 있도록 합니다.

지원 내용

- PDF 지원: 이제 PDF로 직접 연결되는 링크를 제공할 수 있어, Gemini가 텍스트를 추출할 뿐만 아니라 그 안의 표와 전체 구조를 이해할 수 있게 됩니다. 이를 통해 보고서, 논문, 매뉴얼 등을 그라운딩에 온전히 활용할 수 있습니다.

- 이미지 지원: 이제 이 도구는 PNG, JPEG, BMP, WebP 형식을 포함한 이미지를 처리하고 분석할 수 있습니다. 이는 Gemini의 멀티모달 기능을 활용하여 시각적 정보를 이해하고, 차트, 다이어그램 등의 분석 가능성을 열어줍니다.

- 웹 및 데이터 파일: 표준 웹 페이지(HTML), 구조화된 데이터(JSON, XML, CSV), 텍스트 파일(일반 텍스트, RTF, CSS, JavaScript)에 대한 강력한 지원이 계속됩니다.

사용 사례

- 고객 상호작용 개인화: AI 챗봇 에이전트를 고객의 웹 페이지에 그라운딩하여 문의에 대해 정확하고 관련성 높은 답변을 제공

- 문서 비교: 여러 보고서, 기사 또는 PDF를 분석하여 차이점을 식별하고 추세를 추적

- 콘텐츠 합성 및 생성: 여러 소스 URL의 정보를 결합하여 정확한 요약, 블로그 게시물 또는 보고서를 생성

- 코드 및 문서 분석: GitHub 리포지토리 또는 기술 문서를 지정하여 코드를 설명하고, 설치 지침을 생성하거나 기술적인 질문에 답변

Docs :

https://cloud.google.com/vertex-ai/generative-ai/docs/url-context

https://ai.google.dev/gemini-api/docs/url-context?hl=ko

A2A 에이전트를 확장하기 위한 개발자 도구 발표

Agent2Agent(A2A) 에이전트를 구축, 배포, 평가 및 판매할 수 있도록 지원하는 포괄적인 도구 모음을 발표

Google의 오픈 소스 프레임워크인 에이전트 개발 키트(ADK)에서 A2A를 기본으로 지원하여 A2A 에이전트 구축을 용이하게 합니다.

에이전트 배포를 위해 Google Cloud Platform에서는 세가지 경로가 제공 됩니다.

- 쉽게 배포 및 관리가 가능한 환경인 Agent Engine

- 서버리스 인프라를 활용해 대규모 확장성과 안정성을 제공하는 Cloud Run

- 쿠버네티스의 다양한 기능을 활용해 A2A 시스템을 대규모 관리 가능한 GKE

또한, Agent Starter Pack의 CLI 도구를 사용해 단 한줄로 CI/CD 설정을 완료할 수 있습니다.

#example

uvx agent-starter-pack create my-agent -a adk@gemini-fullstackAgentspace는 에이전트와 사용자가 만나는 안전한 환경으로, 자신의 A2A 에이전트를 Agentspace에 서비스로 제공할 수 있습니다. 또한 A2A 프로토콜은 커뮤니티 주도 표준을 위해 리눅스 재단에 기여 되었습니다

GitHub에서 Gemini Code Assist를 사용한 코드 리뷰 개선

Gemini Code Assist를 GitHub 워크플로우에 통합하여 코드 리뷰 프로세스를 개선합니다.

코드 리뷰의 문제점과 해결책

코드 리뷰는 소프트웨어 개발의 필수적인 부분이지만, 종종 개발 속도를 늦추는 병목 현상이 되곤 합니다. 연구에 따르면 코드 리뷰 시간을 단축하는 팀은 소프트웨어 배포 성과가 50% 더 좋습니다. 이러한 문제를 해결하기 위해 GitHub Workflow에 Gemini Code Assist를 통합하여 Pull Request에 적용해 고품질의 일관된 코드를 보장합니다.

AI 기반의 Pull Request(PR)시 주요 기능 및 장점

- 즉각적인 PR 요약 : 변경 사항에 대한 포괄적인 요약을 즉시 제공하여 인적 검토자가 빠르게 내용을 파악

- 자동화된 심층 리뷰 : 잠재적 버그, 스타일 문제, 모범 사례 위반 등을 식별하여 검토자가 더 복잡한 아키텍처 결정에 집중할 수 있도록 함

- 대화형 지원 및 학습 : PR에 있는 누구나

/gemini명령을 사용하여 AI와 대화해 다른 구현 방식을 요청하거나 새로운 리뷰를 받을 수 있음

Gemini 2.5를 통한 성능 향상

Gemini Code Assist는 최신 모델인 Gemini 2.5에서 실행되도록 업그레이드 됨에 따라 코드의 논리와 의도를 더욱 잘 이해하여 잠재적 버그를 찾아내고, 고객별 스타일 가이드와 구성을 AI가 학습하여 생성된 코드가 정확하고 문맥을 잘 파악 합니다. 매우 신뢰할 수 있는 AI의 제안과 신속성으로 커밋의 반복 주기가 빨라 질 수 있습니다.

고객 사례: Delivery Hero

글로벌 배달 플랫폼인 Delivery Hero는 Gemini Code Assist: GitHub App을 조기에 도입하여 코드 품질과 개발자 만족도에서 긍정적인 효과를 보았습니다.

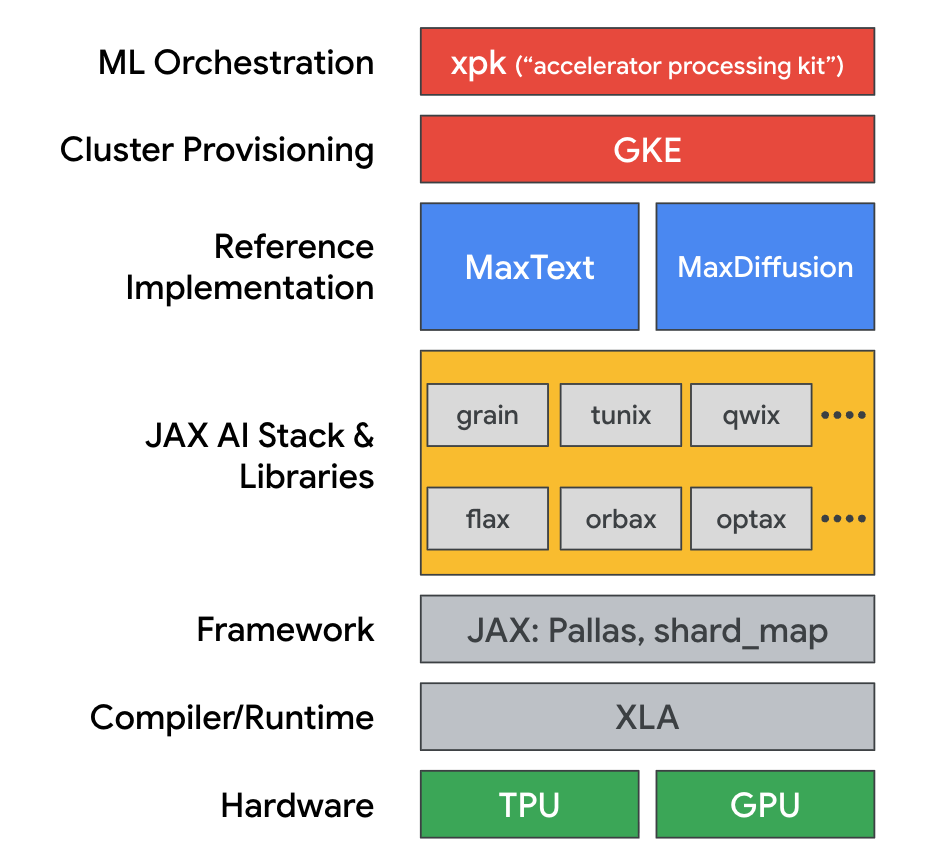

카카오의 JAX 및 클라우드 TPU와의 여정

카카오톡의 엔지니어링팀은 기존 GPU 기반 인프라가 전력 및 예산의 한계에 Google Cloud TPU와 JAX 프레임워크로 전환 하였습니다.

주요 기술적 성과

- 데이터 파이프라인 맞춤화: 카카오는 기존 MaxText 프레임워크를 수정하여 여러 데이터 소스를 동적으로 혼합하고, 기존 Megatron-LM 파이프라인과의 호환성을 유지하며 효율성을 높이는 토큰 처리 방식을 구현했습니다.

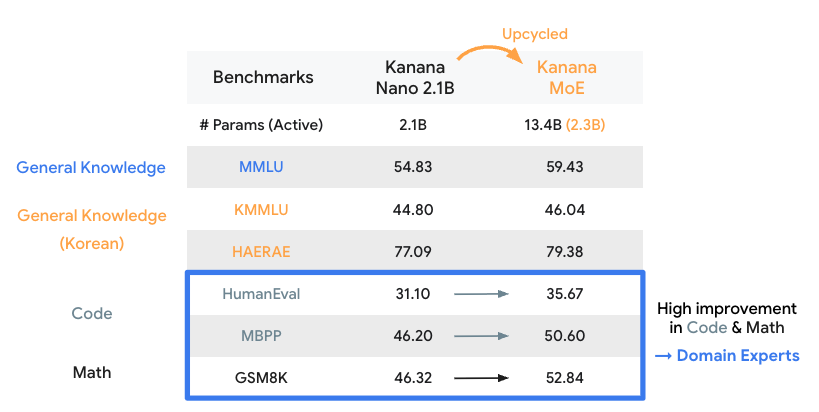

- TPU 환경 검증: 새로운 TPU 기반 워크플로우에서 Kanana 2.1B 모델을 성공적으로 훈련시켜 기존 GPU 환경과 동등한 성능을 재현하는 데 성공했습니다.

- 전문가 혼합(MoE) 모델 훈련: 검증된 파이프라인을 바탕으로, 기존의 21억 파라미터 모델을 134억 파라미터의 MoE 모델로 성공적으로 ‘업사이클링’하여 훈련시켰습니다. 그 결과, 특히 코드와 수학 관련 벤치마크에서 성능이 향상되는 것을 확인했습니다.

- Trillium TPU를 통한 성능 향상: 차세대 Trillium TPU를 조기 도입한 결과, 기존 v5e TPU 대비 처리량이 2.7배 증가하는 등 즉각적이고 상당한 성능 및 비용 효율성 개선을 경험했습니다.

카카오의 사례는 JAX 스택과 Cloud TPU가 대규모 언어 모델 개발에 얼마나 효율적이고 유연한 환경을 제공하는지 보여주며, 카카오팀이 꼽은 주요 장점은 다음과 같습니다.

- 성능과 확장성: JAX와 XLA의 컴파일 최적화 및 MaxText의 대규모 병렬 컴퓨팅 지원

- 높은 수준의 맞춤화 및 제어: 순수 Python 기반의 코드베이스로, 맞춤형 파이프라인과 새로운 아키텍처 구현이 용이함

- 신속한 최신 기능 도입: MaxText 프레임워크가 최신 모델의 기능들을 빠르게 업데이트하여 연구를 최신 상태로 유지 가능

비용최적화를 위한 Cloud Hub Optimization 및 Cost Explorer

클라우드 비용을 최적화 하기 위해 ‘가장 비용이 높은 리소스는 무엇인가?’, ‘활용도가 낮은 리소스는 무엇인가?’와 같은 질문에 빠르게 답할 수 있는 Cloud Hub Optimization과 Cost Explorer가 Public Preview 제공

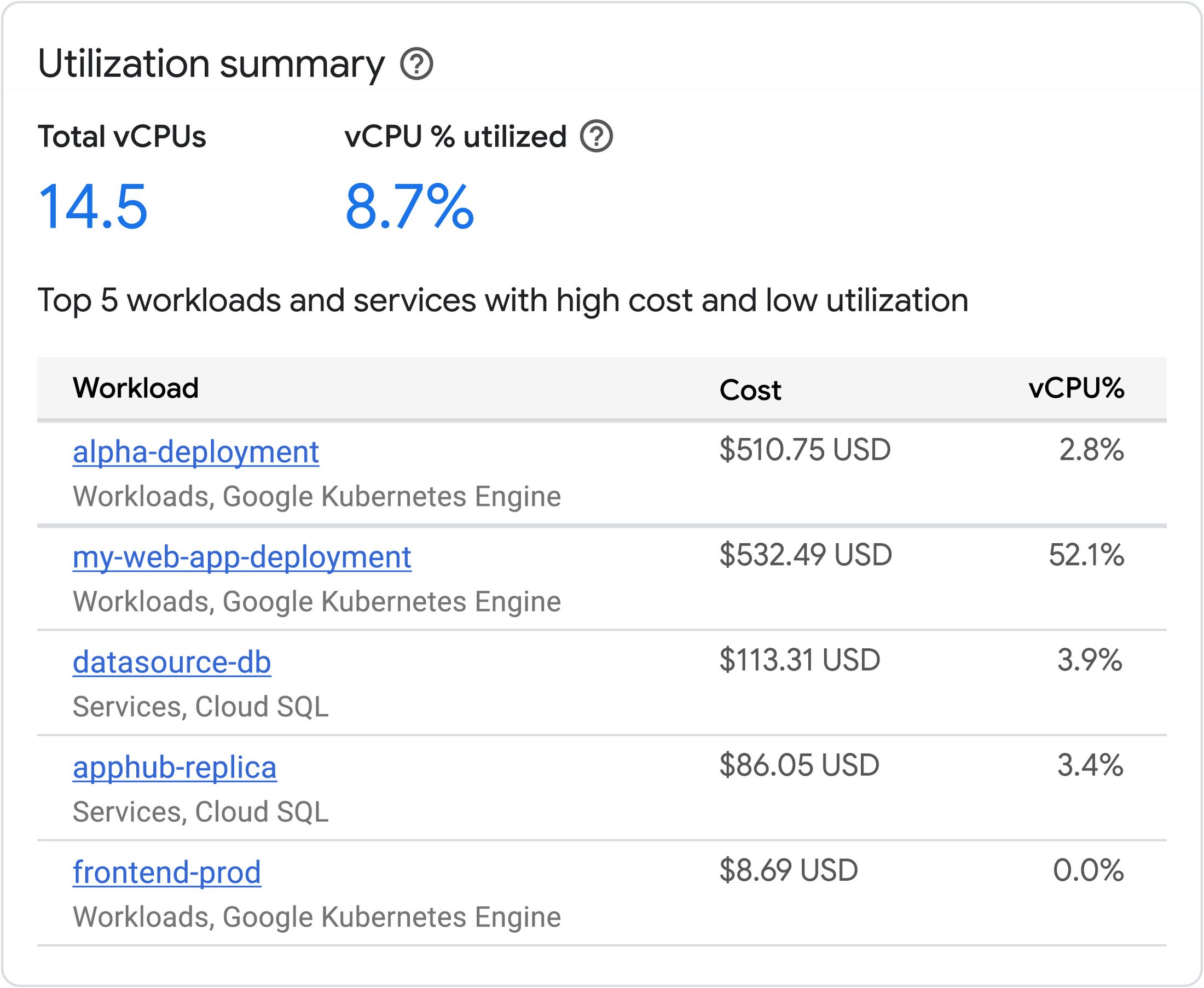

애플리케이션 비용 및 활용도

수십 개의 프로젝트에 걸쳐 있는 애플리케이션의 모든 개별 구성 요소를 모니터링 하는 것은 어려울 수 있기 때문에 AppHub Application을 사용하면 애플리케이션 중심으로 필요한 정보와 제어 기능을 손쉽게 확인할 수 있습니다. 또한 애플리케이션 워크로드 및 서비스의 비용 효율성을 즉시 보여줍니다.

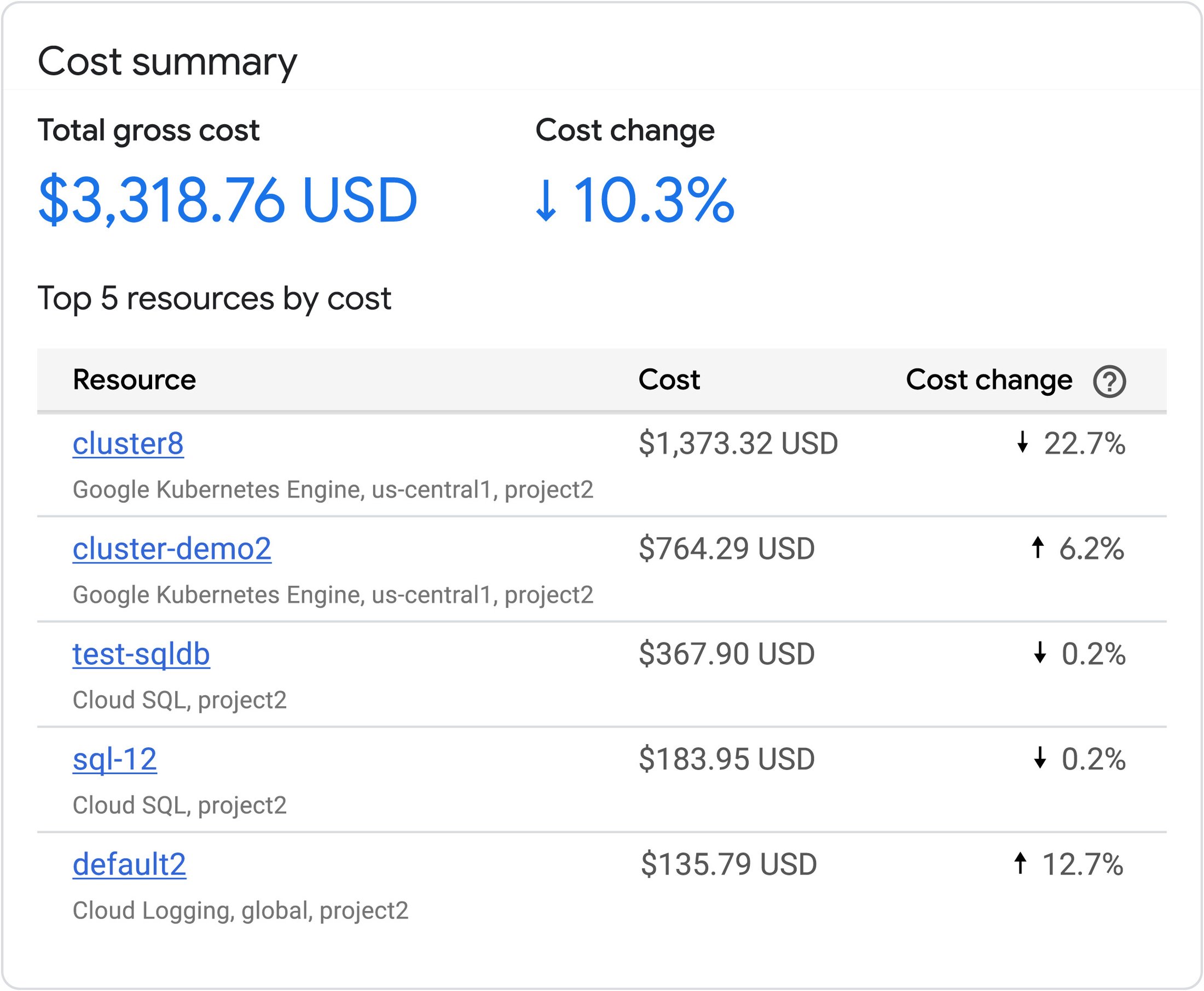

비용 대쉬보드 그 이상의 기능

비용 대쉬보드 그 이상의 기능

Cloud Hub Optimization을 실행하면 가장 비용이 많이 드는 리소스와 해당 비용의 변화율을 즉시 확인할 수 있습니다. 또한 세분화된 비용 정보를 통해 특정 자원과 특정 자원의 소유자를 기반으로 비용 변화 확인이 가능합니다.

Cloud Billing의 세분화된 비용 데이터와 Cloud Monitoring의 리소스 활용도 데이터를 통합하여 비용 효율성에 대한 표괄적인 그림을 제공 합니다.

Cost Explorer 대시보드는 비용 설명 기능을 높이기 위해 제품 수준에서 세분화된 구성 비용도 제공 합니다. 예를 들어 Compute Engine의 총 비용을 보는 대신 GKE, Persistent Disk, Cloud Load Balancing 등의 개별 제품에 대한 정확한 비용을 볼 수 있습니다.