2025년 AI 시장을 한 마디로 요약하면 Agentic AI의 시대로 정리할 수 있습니다. 구글 클라우드가 지난 해 AI 에이전트를 Google Cloud Next 행사에서 강조한 지 1년이 지났을 뿐인데 시장은 여러 AI 에이전트가 상호 협력해 작업을 자율적으로 처리하는 Agentic AI를 프로덕션 환경에서 구현할 수 있는 단계에 이르렀습니다. 이번 포스팅에서는 2026년부터 엔터프라이즈의 AI 투자를 주도할 Agentic AI 관련해 구글 클라우드가 어떻게 엔터프라이즈의 복잡하고 까다로운 요구 사항을 충족하고 있는지 살펴보겠습니다.

구글 클라우드의 Agentic AI 전략

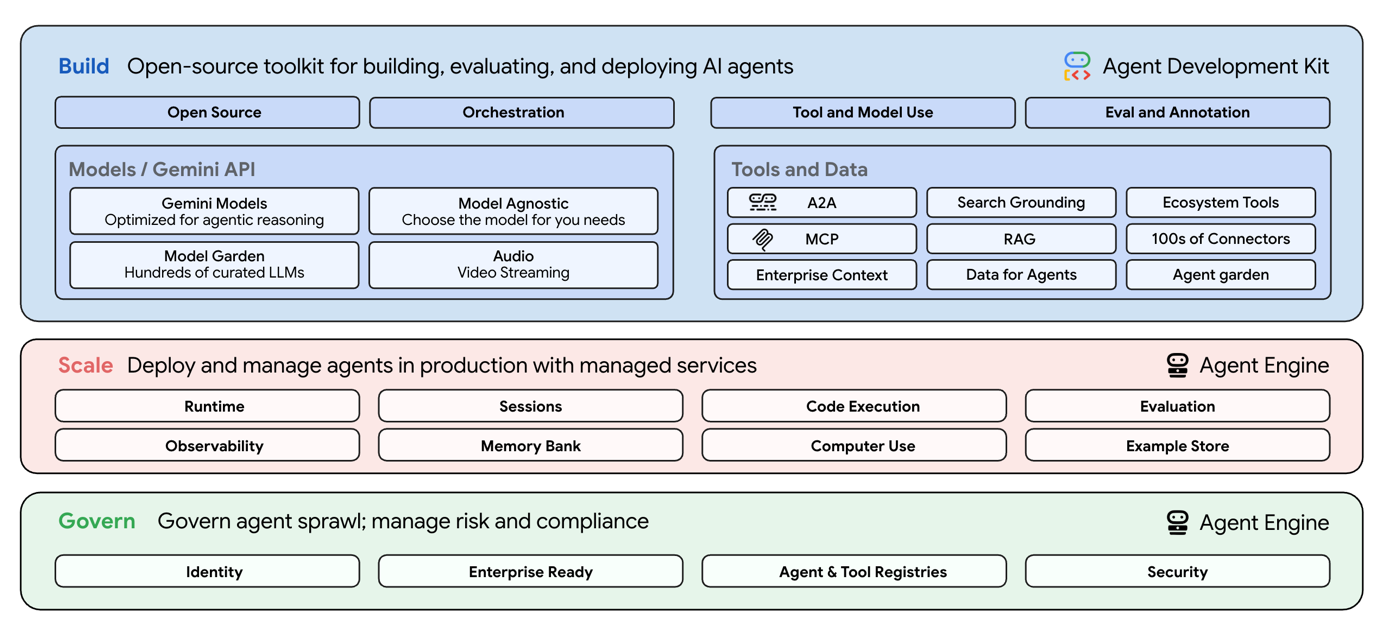

구글 클라우드는 단순히 성능 좋은 모델을 제공하는 것을 넘어 AI 에이전트의 생성부터 확장, 관리까지 전체 수명 주기를 혁신하는 데 필요한 기술을 포괄적으로 제공합니다. Agentic AI를 위한 모든 것을 갖추고 있다고 이해하면 됩니다.

구글 클라우드 Agentic AI 전략은 개방형 생태계에 뿌리를 내리고 있습니다. 구글 클라우드는 A2A(Agent-to-Agent) 프로토콜을 통해 서로 다른 에이전트가 상대를 식별하고 안전하게 소통할 수 있는 표준을 만들고 있습니다. 여기에 Anthropic이 개발한 MCP(Model Context Protocol)를 더해 AI 에이전트가 기업 데이터베이스나 시스템에 쉽게 연결되도록 지원합니다.

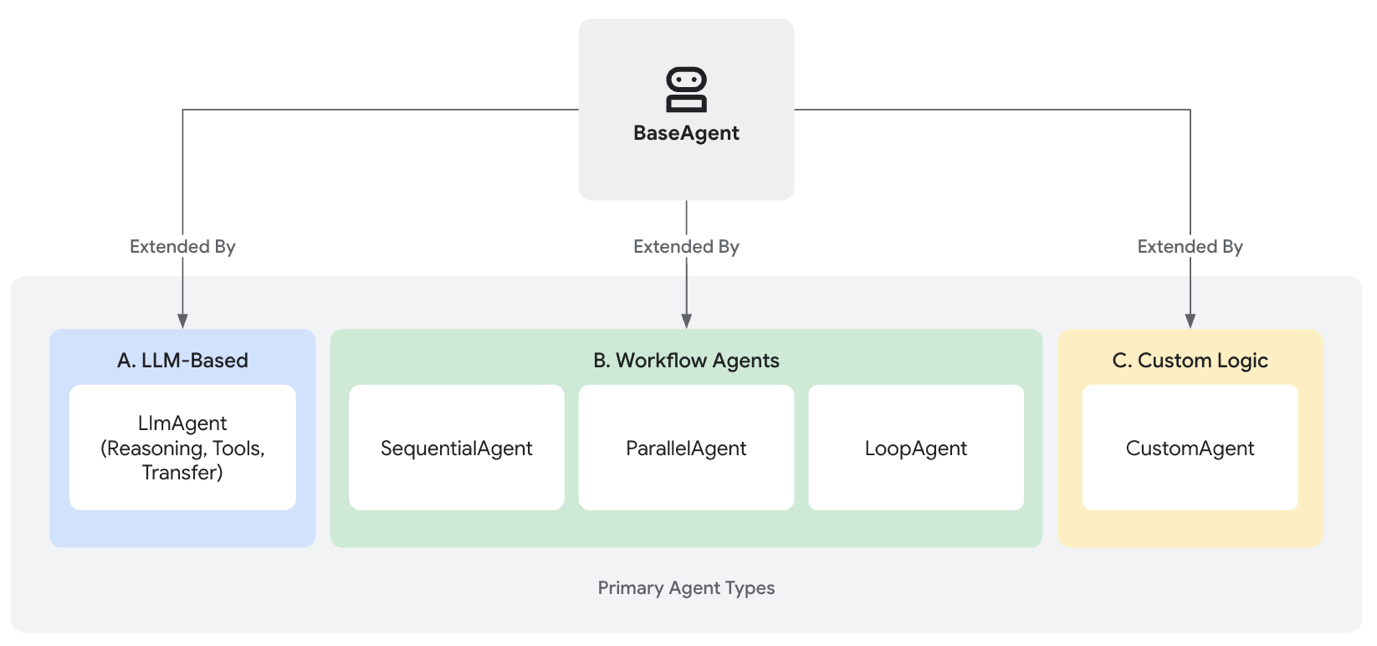

개방형 표준과 오픈 소스 기반 생태계를 디딤돌 삼아 구글 클라우드는 멀티 AI 에이전트 구현과 운영에 필요한 도구와 플랫폼을 제공합니다. 이는 AI 에이전트의 전체 생명주기를 아우릅니다. 구현 단계부터 보자면 ADK(Agent Development Kit)를 활용하면 정교한 AI 에이전트를 만들 수 있습니다.

만약 로코드/노코드 도구로 프로타이핑을 하고 싶다면 Vertex AI Agent Builder를 활용하면 됩니다. ADK를 이용하면 엔터프라이즈가 요구하는 복잡한 워크로드의 로직을 충실히 반영한 AI 에이전트를 개발할 수 있습니다. 쉽게 말해 정교함이 요구되는 작업은 ADK로 현업 사용자가 자신이 원하는 단순한 구조의 대화형 AI 에이전트의 프로토타입을 만들어 보고 싶다면 Vertex AI Agent Builder를 구현 도구로 활용하면 됩니다.

만약 로코드/노코드 도구로 프로타이핑을 하고 싶다면 Vertex AI Agent Builder를 활용하면 됩니다. ADK를 이용하면 엔터프라이즈가 요구하는 복잡한 워크로드의 로직을 충실히 반영한 AI 에이전트를 개발할 수 있습니다. 쉽게 말해 정교함이 요구되는 작업은 ADK로 현업 사용자가 자신이 원하는 단순한 구조의 대화형 AI 에이전트의 프로토타입을 만들어 보고 싶다면 Vertex AI Agent Builder를 구현 도구로 활용하면 됩니다.

프로덕션 환경에 배포할 수 있는 수준의 AI 에이전트 개발을 마쳤다면 이후 배포하고 관리하는 것은 Vertex AI Agent Builder가 담당합니다. ADK로 개발한 경우 Vertex AI Agent Builder의 런타임 환경인 Agent Engine에 배포해 실행하면 됩니다. 이후 모니터링, 버전 관리, 보안 설정 등의 작업은 Vertex AI Agent Builder에서 수행하면 됩니다.

플랫폼 엔지니어링으로 자원 활용 최적화

멀티 AI 에이전트를 구현해 프로덕션 환경에 배포해 운영하는 단계에 이르면 자연스럽게 관심사가 플랫폼 엔지니어링으로 바뀝니다. 멀티 AI 에이전트 활용 관련 사용자 경험과 비용에 직결되는 것이 플랫폼 엔지니어링이기 때문입니다. 좀 더 자세히 들여다 보겠습니다.

AI 에이전트의 워크로드는 훈련(Tanning)과 특성이 다릅니다. 추론(Inferencing)을 하다 보니 연산량이 많고 변동 폭도 큽니다. 따라서 고가의 GPU와 TPU 가속기와 여기에 장착된 메모리를 효율적으로 쓰고 비용을 줄이는 플랫폼 엔지니어링 역량이 무엇보다 중요합니다.

구글 클라우드 환경에서는 플랫폼 엔지니어링이 누구나 도전할 수 있는 목표입니다. AI 인프라 운영의 부담을 줄이려면 GKE Autopilot을 활용하면 됩니다. 워크로드에 맞춰 인프라를 자동으로 준비해주기 때문에 엔지니어는 노드 관리에서 해방됩니다. 여기에 워크로드 스케줄러를 결합하면 비용 효율을 극대화할 수 있습니다. 급한 작업은 용량을 미리 예약하고 학습처럼 시간 여유가 있는 작업은 유휴 자원을 활용해 비용을 절감할 수 있습니다.

모델을 효율적으로 운영하기 위한 메모리 최적화 기술도 필수입니다. 양자화(Quantization) 기술을 적용해 모델 웨이트를 4비트나8비트로 줄이면 단일 GPU에서도 거대 모델을 구동할 수 있습니다. 또한, vLLM을 활용하면 추론 환경에서 메모리 병목 현상을 해결하고 처리 속도를 높일 수 있습니다. 참고로 구글 클라우드에서는 Vertex AI, GKE 같은 다양한 선택지를 통해 양자화 적용과 vLLM을 활용할 수 있습니다.

모델 오케스트레이션

멀티 AI 에이전트가 엔터프라이즈 환경에서 사람과 함께 일하는 AI 동료로 자리를 잡으려면 용도와 목적에 맞는 모델 성능을 제공해야 합니다. 이런 이유로 멀티 AI 에이전트를 활용하는 곳을 가보면 하나의 모델이 아니라 여러 모델을 활용합니다. 작업 특성에 맞는 모델을 골라 쓰는 구조라 보면 됩니다.

이를 구현하는 핵심은 모델 라우팅 아키텍처입니다. 이를 통해 다양한 모델을 유연하게 활용할 수 있을 뿐만 아니라 비용 최적화도 가능합니다. 예를 들어 단순한 정보 검색이나 요약은 빠르고 저렴한 텍스트 전용 모델인Gemma 2, Llama 3 등에 맡기고 이미지 분석이나 복잡한 추론이 필요한 경우 고성능 멀티모달 모델인 Gemini 3를 호출하는 방식입니다. 이를 위해 게이트웨이나 경량화된 라우터를 두어 입력 데이터를 분석하고 적절한 모델로 트래픽을 보내는 구조를 설계해야 합니다. 구글 클라우드 환경에서는 LangGraph 프레임워크를 사용하거나 Gemini 1.5 Flash 같은 경량 모델을 라우터로 활용하는 것을 고려해 볼 수 있습니다.

한편 라우팅을 지원하는 경우 멀티 모달 모델 관련 비용 부담을 줄여야 합니다. 멀티 모달 모델은 다재다능함과 강력한 성능을 보여주는 만큼 리소스 소모가 많습니다. 구글 클라우드에서는 플랫폼 엔지니어링을 통해 리소스 부담을 줄일 수 있습니다. 이는 크게 세 가지 측면에서 전략을 짤 수 있습니다. 첫 번째는 워크로드에 최적화된 가속기를 선택하는 것입니다. 구글 클라우드에는 TPU라는 대안이 존재합니다. 두 번째는 GKE Autopilot이나 Cloud Batch 같은 자동화 기잔 관리형 서비스를 활용하는 것입니다. 세 번째는 Axolotl 같은 파인 튜닝 과정을 간소화화는 오픈 소스 프레임워크를 활용하는 것입니다.

확신을 주는 기술 스택

Agentic AI를 엔터프라이즈 컴퓨팅 환경에 구현하는 것은 단순한 신기술 적용이 아닙니다. 기업의 IT 아키텍처를 근본적으로 혁신하는 과정입니다. 성공적인 도입을 위해서는 먼저 안정적인 플랫폼 기반을 마련해야 합니다. 그 위에 적절한 도구로 비용 효율적인 구조(FinOps)를 갖추고 A2A나 MCP 같은 개방형 표준으로 시스템을 연결해야 합니다. 마지막으로 도메인에 특화된 모델을 활용해 실질적인 비즈니스 가치를 창출해야 합니다. 구글 클라우드의 생태계와 앞서 소개한 도구와 플랫폼 기술 스택을 보면 Agentic AI 도입의 불확실성을 확실히 줄일 수 있다는 확신을 가질 수 있습니다. 더 자세한 내용이 궁금하시자면 메가존소프트로 문의 바랍니다.